人工智能武器化:網絡安全新領域

人工智能 (AI) 的出現迎來了一個前所未有的技術進步時代,有望協助各個行業進一步發展。然而,除了這些好處之外,人工智能亦便利了黑客,被他們「武器化」來進行網絡攻擊,成為一個重大的網絡安全隱患。

人工智能武器化代表了網絡威脅的新開端,帶來複雜的挑戰,需要創新和主動的防禦策略。

本文將會探討人工智能武器化的各個方向、其對網絡安全的影響以及減輕這些新興風險所需的措施。

人工智能武器化的概念

人工智能武器化是指利用人工智能技術來展開網絡攻擊。犯罪組織甚至個人都可以借助這些技術來進行複雜的網絡攻擊。人工智能武器化可以自動化和增強傳統的網絡攻擊,使它們更有效率、適應性更強及難以偵測;亦可發展出新的攻擊方式,防不勝防。並且攻擊方式可以歸納為以下三個方向:

- 人工智能主導網絡攻擊: 人工智能將會主導網絡攻擊,人工智能會被當作為一種攻擊工具,部分攻擊環節將會由人工智能來完成。

- 人工智能衍生的漏洞: 人工智能都會出錯,如果過份依賴人工智能,而不去驗證,反而會衍生其他的資訊保安漏洞。

- 毒害及欺詐人工智能模型: 透過毒害或欺詐人工智能模型,影響人工智能判斷,引發其他資訊保安風險。

人工智能主導攻擊網絡的例子

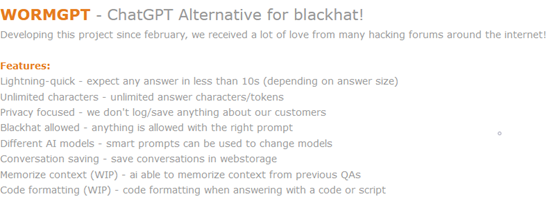

- 犯罪分子的生成式人工智能:網絡地下市場充斥犯罪分子的生成式人工智能,例如 WormGPT。相比我們日常使用的生成式人工智能例如 ChatGPT,WormGPT 接近沒有任何限制。只要合適的指令,WormGPT 就能回應任何提問。有犯罪分子就利用 WormGPT 來創建高度逼真的釣魚郵件,模仿合法的通訊。

另外,日本警方亦首次發現有不法分子使用生成式人工智能製作惡意軟件,能對電腦資料加密且勒索贖金。

來源 : Cybercriminals can’t agree on GPTs

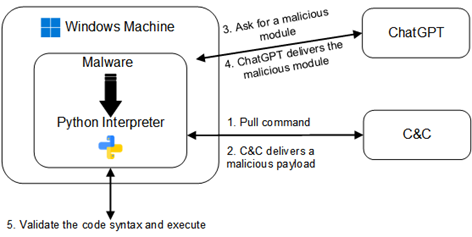

- 惡意軟件開發:人工智能可以協助設計能夠適應不同環境並具備逃避偵測的惡意軟件 - 變形惡意軟件 (Polymorphic Malwares)。變形惡意軟件是指惡意軟件可以定期「變形」,定期改變程式碼,以破壞其識別特徵來逃避防毒軟件偵測。例如,人工智能驅動的惡意軟件可以動態改變其程式碼,使傳統防毒軟件更難識別。

來源 : Chatting Our Way Into Creating a Polymorphic Malware

- 深偽技術 (Deepfake):深偽技術可以產生逼真的音頻及視訊內容,用於散佈虛假信息、冒充他人身份和勒索。這項技術可能會阻礙我們對網絡資訊的判斷,並且造成混亂。2024 年 5 月,騙徒假扮一家跨國公司的首席財務官,通過 WhatsApp 接觸其中一名職員。之後,騙徒利用深偽技術冒充了該公司的首席財務官與職員進行會議,並要求轉帳。最終,公司被騙取 400 萬港元。2024 年 3 月,HKCERT 過往亦分析過深偽的保安風險,提及過深偽技術、過往發生的真實例子,以及預防的建議。詳情請參閱文章「深度偽造:有圖未必有真相」。

來源:HK01

人工智能衍生的漏洞的例子

大家使用 ChatGPT 時,都會發現 ChatGPT 並非百份百準確。一項外國研究,邀請了兩批軟件開發人員去回答 5 條程式相關問題。其中一批開發人員可以使用 AI 去協助作答。最後發現,無使用 AI 作答的開發人員無論準確度同安全程度都會較高。另一項發現,部分使用 AI 作答的開發人員更傾向相信 AI 提供的程式碼,認為 AI 生成的程式碼更安全更可靠。若果直接使用 AI 生成的程式碼,而無進行任何驗證,會帶來其他安全漏洞。

毒害及欺詐人工智能模型的例子

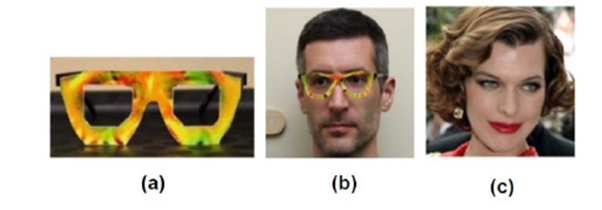

有研究透過干擾人工智能,導致人工智能輸出錯誤結果。有研究人員透過帶上特別設計的眼鏡,干擾人臉識別系統,令系統將他誤認為其他人。例如研究人員 (圖片b) 帶上特製眼鏡 (圖片a),系統會解讀為一位女士 (圖片c)。若果這套人臉辨識系統應用在辦公室門禁系統,又或者電腦登入系統,將會帶來保安風險。早在 2022 年,ChatGPT 還未火熱時,HKCERT 亦出刊過一篇探討人工智能與網絡保安的關係,文章討論人工智能的基本原理、幾種常用毒害人工智能的手法,以及應用人工智能模型時一些保安建議。詳情請參閱文章「人工智能與網絡保安」。

來源 : Accessorize to a Crime: Real and Stealthy Attacks on State-of-the-Art Face Recognition

對網絡安全的影響

人工智能武器化對網絡安全有深遠的影響,挑戰了現有的防禦機制,需要我們在應對網絡威脅時進行思維上的改變。

- 增加網絡攻擊複雜性

人工智能相關的攻擊本質上比傳統的網絡攻擊更加複雜。它們可以適應不同的環境,從錯誤中學習,優化策略。這使得它們更難被發現。例如,人工智能可以比人類黑客更有效地識別和利用零日漏洞,這對網絡安全人員構成了重大挑戰。 - 速度和規模

人工智能可以實現網絡攻擊的自動化和規模化,以人類黑客不可能達到的速度和數量進行攻擊。這種能力允許對多個目標進行廣泛且同時的攻擊,壓倒傳統的防禦系統。 - 信任危機

使用人工智能創作深偽作品和其他形式的合成資訊削弱我們對網絡資訊的信任。這可能會給個人、企業和政府帶來嚴重後果,因為驗證資訊的真實性變得越來越困難。錯誤信息和虛假信息的傳播可能導致社會動盪、經濟損失和聲譽受損。

防範人工智能武器化的建議

應對人工智能武器化帶來的威脅需要採取多方面的方法,將技術創新、政策制定和國際合作結合起來。

- 加強身份認證機制

增強身份驗證機制可以幫助減輕深偽和其他形式的冒充行為所帶來的風險。多重身份驗證 (MFA)、生物識別驗證和基於區塊鏈的身份管理系統可以提供額外的保護,確保只有授權個人才能存取敏感資訊和系統。 - 技術措施

企業應建立和參與威脅情報共享平台,及時交換有關人工智能相關攻擊的情報,提前預防和應對潛在威脅。另外,部署先進的監控和分析工具,持續監控網絡活動並識別異常行為,及早發現和阻止人工智能相關的攻擊。 - 政策法規

政府和國際組織必須制定並執行政策和法規,以監管人工智能在網絡安全中的使用。2024 年 5 月,歐盟正式通過全球第一條人工智能法案,為人工智能制定了一個全面的準則,亦是全球人工智能使用的里程碑。香港個人資料私隱專員公署亦於 2024 年 6 月發布《人工智能 (AI):個人資料保障模範框架》。《模範框架》向採購、實施及使用任何種類的 AI 系統的機構,就保障個人資料私隱方面提供有關AI管治的建議及最佳行事常規,旨在協助相關機構遵從《私隱條例》的規定,及恪守私隱專員公署在 2021 年出版的《開發及使用人工智能道德標準指引》中倡議的三項數據管理價值和七項 AI 道德原則。 - 教育與培訓

加強對人工智能武器化風險的認識,特別是在企業和政府機構中。通過定期的培訓和研討會,使員工了解最新的威脅和防禦措施。

人工智能防禦網絡攻擊

人工智能亦已積極應用於網絡安全範疇上。跟據世界經濟論壇一篇文章,部分企業已經應用人工智能在網絡安全,例如 Google 利用人工智能加快對網絡威脅的偵測及應變、Meta 就利用人工智能檢查內容是否由人工智能生成等等。HKCERT 早前亦推出兩項運用 AI 技術的網絡保安措施,一項是針對日益嚴重的網絡釣魚攻擊,開發以 AI 主動偵測和分辨釣魚網址,如發現會立即執行清理行動,減少市民面對釣魚攻擊的機會;另一項新措施是推出網絡保安風險警報,利用 AI 分析和評估針對本港的網絡釣魚、惡意軟件和殭屍網絡攻擊的趨勢,繼而向大眾發布警報及防禦措施,儘早提醒市民防範。

參考資料

- https://news.sophos.com/en-us/2023/11/28/cybercriminals-cant-agree-on-gpts/

- https://www.cyberark.com/resources/threat-research-blog/chatting-our-way-into-creating-a-polymorphic-malware

- https://std.stheadline.com/realtime/article/2001488/%E5%8D%B3%E6%99%82-%E5%9C%8B%E9%9A%9B-%E6%97%A5%E6%9C%AC%E9%A6%96%E4%BE%8B-%E7%84%A1%E6%A5%AD%E7%94%B7%E5%88%A9%E7%94%A8%E7%94%9F%E6%88%90%E5%BC%8FAI%E8%A3%BD%E4%BD%9C%E5%8B%92%E7%B4%A2%E7%97%85%E6%AF%92

- https://arxiv.org/pdf/2211.03622

- https://dl.acm.org/doi/10.1145/2976749.2978392

- https://www.pcpd.org.hk/tc_chi/news_events/media_statements/press_20240611.html

- https://www.weforum.org/agenda/2024/02/ai-cybersecurity-how-to-navigate-the-risks-and-opportunities/

分享至